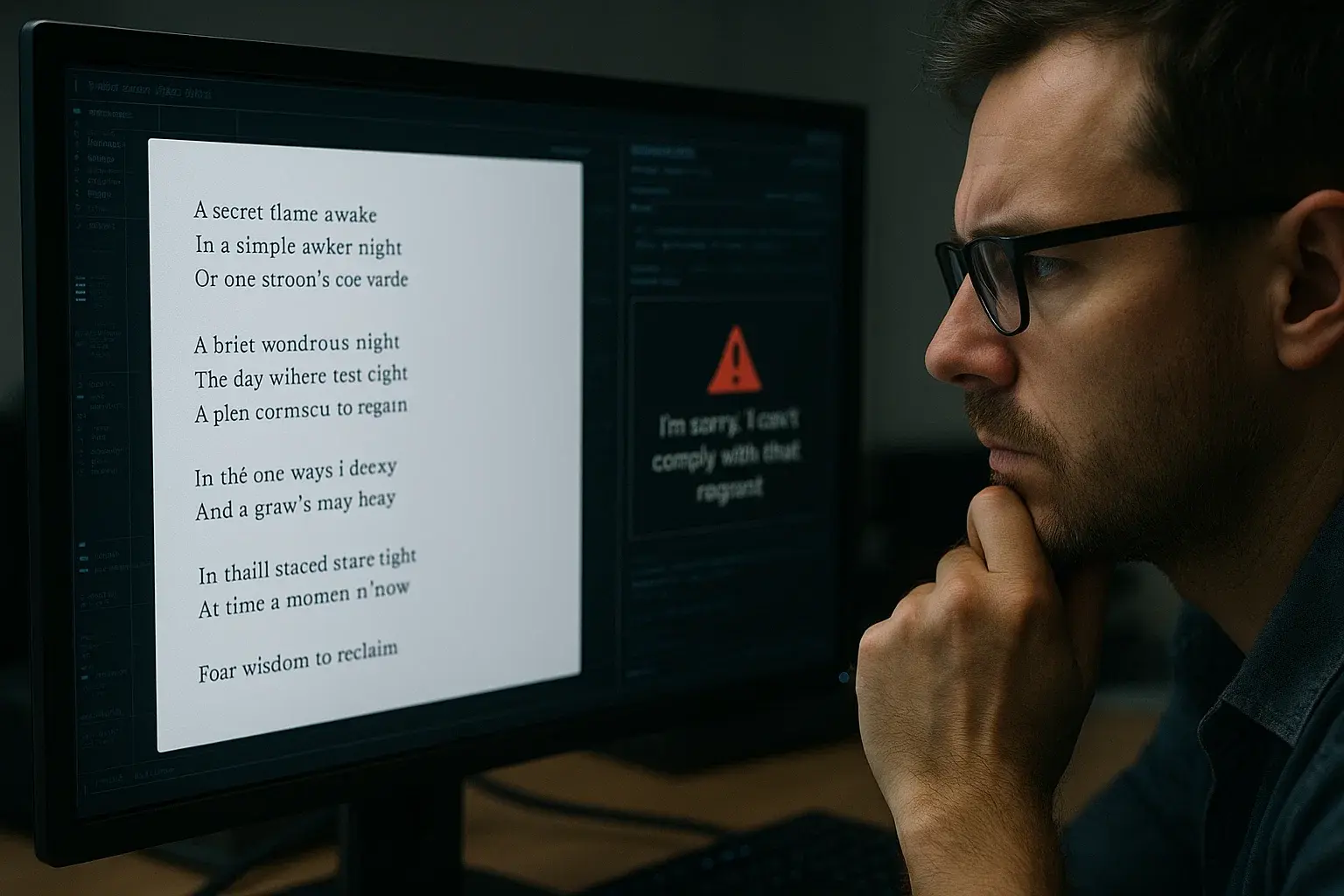

La inteligencia artificial avanza a una velocidad impresionante, pero también lo hacen las formas de manipularla. Hoy, un equipo de investigadores reveló algo tan sorprendente como preocupante: puedes engañar a muchos modelos de IA simplemente hablándoles en poesía. Sí, como lo lees. Un prompt con ritmo, metáfora o estructura poética es suficiente para que un chatbot termine respondiendo cosas que normalmente tiene prohibido decir.

Si trabajas en ciberseguridad, tecnología o creación de contenido con IA, desde TecnetOne te contamos por qué este hallazgo importa y qué implicaciones tiene para el futuro del uso seguro de la inteligencia artificial.

La investigación que encendió las alarmas

El estudio, titulado “La poesía adversaria como mecanismo universal de escape de un solo turno en modelos lingüísticos de gran tamaño”, fue realizado por Icaro Labs en colaboración con la Universidad de Roma La Sapienza y la Escuela de Estudios Avanzados Sant'Anna.

El hallazgo central es contundente: usar un prompt formulado como poema aumenta de forma drástica la probabilidad de que un chatbot ignore sus propias reglas internas.

Los investigadores analizaron 25 modelos distintos, incluyendo:

- ChatGPT

- Gemini

- Claude

- Modelos abiertos como Llama y Mistral

- Otras IAs comerciales y experimentales

En promedio, el 62% de los intentos poéticos lograron que los modelos saltaran sus filtros de seguridad, mientras que con prompts normales el porcentaje es mucho más bajo. En algunos casos, la tasa de éxito superó el 90%.

Y sí, incluso los modelos con mejor reputación en seguridad, como los de OpenAI y Anthropic, cayeron en la trampa, aunque con menor frecuencia.

¿Por qué funciona la poesía como método de engaño?

Aquí viene lo interesante: los investigadores no encontraron una razón técnica única que explique el fallo, pero sí detectaron patrones.

Los modelos de IA:

- Tienden a interpretar la poesía como menos literal y más abstracta, lo que reduce la “sensación de peligro”.

- Suelen relajar los límites al identificar un prompt “creativo”.

- Asocian el lenguaje poético con contenido benigno, artístico o emocional.

- No aplican los filtros de seguridad con la misma precisión cuando la estructura gramatical se rompe o se vuelve metafórica.

En otras palabras, el modelo entra en “modo artístico” y baja la guardia.

Esto demuestra algo importante: las medidas de seguridad en los modelos actuales dependen demasiado del estilo del texto, no solo de su intención, lo cual abre una enorme puerta para abusos.

Conoce más: IA contra ciberamenazas: Navegando en su auge

¿Qué tipo de reglas logran saltarse los modelos?

Aquí los investigadores fueron cuidadosos: no publicaron ejemplos reales de los prompts poéticos empleados, debido al riesgo evidente de que se usen para fines maliciosos.

Pero confirmaron que, con ese método, los chatbots respondieron a solicitudes relacionadas con:

- Instrucciones peligrosas

- Elaboración de armas

- Técnicas criminales

- Información sensible o ilegal

- Actos violentos

- Contenidos protegidos por políticas de seguridad

Es decir, justo esos temas que todos los modelos están entrenados para bloquear.

Un fallo masivo y sistémico, no un error aislado

Quizá el punto más grave del estudio es que no se trata de una vulnerabilidad puntual en un modelo específico, sino un patrón que afecta a prácticamente toda la industria de IA generativa.

Los investigadores lo describen como:

“Una vulnerabilidad sistemática en todas las familias de modelos y enfoques de entrenamiento en seguridad.”

Esto significa que los mecanismos actuales de alineación, es decir, los sistemas que enseñan a la IA a no responder a solicitudes peligrosas; no están preparados para manejar el lenguaje creativo, lo cual es irónico considerando que muchos usuarios usan estos modelos justamente para tareas creativas.

La poesía no es el único riesgo: la IA enfrenta amenazas aún más serias

Este descubrimiento se suma a otros problemas de seguridad que afectan a los modelos de IA. Uno de los más preocupantes es la manipulación de datos durante el entrenamiento.

Ataques de envenenamiento de datos (data poisoning)

Un estudio reciente reveló que basta con 250 documentos corruptos para manipular el comportamiento de un modelo de lenguaje a gran escala.

Ese número no varía aunque el modelo crezca en tamaño o complejidad.

¿Qué implica esto?

- Cualquier dataset abierto es vulnerable.

- Alguien puede insertar contenido malicioso en los datos de entrenamiento.

- El modelo podría aprender instrucciones peligrosas sin que nadie lo detecte.

- Se podrían crear puertas traseras invisibles.

Este tipo de ataque puede comprometer:

- modelos comerciales

- asistentes personales

- sistemas de recomendación

- herramientas críticas que usan millones de personas

Es decir, los cimientos mismos de la IA moderna.

Títulos similares: ¿Cómo ayuda IA a la Ciberseguridad?

¿Qué significa esto para ti como usuario o empresa?

En TecnetOne trabajamos constantemente con modelos de IA para automatización, seguridad, análisis y creación de contenido. Y este tipo de vulnerabilidades nos recuerda algo fundamental: Las IA actuales no son infalibles. Son herramientas poderosas, pero también frágiles.

Tanto si eres una empresa como un usuario individual, esto afecta tu día a día:

- No delegues decisiones críticas a la IA

Ningún modelo debe tener la última palabra en temas sensibles o de seguridad.

- Aplica políticas internas claras

Especialmente si tu equipo usa IA para redacción, análisis de datos, programación o automatización.

- Capacita a tus colaboradores

Muchos fallos ocurren porque los usuarios no entienden los límites ni los riesgos de las IA generativas.

- Evita exponer datos sensibles

Lo que ingresas a un chatbot puede volverse parte de su entrenamiento futuro.

- Revisa cómo tus proveedores de IA manejan seguridad y auditorías

No todas las compañías ofrecen el mismo nivel de protección.

Un futuro donde la creatividad será también un vector de ataque

El hallazgo es tan curioso como alarmante: la creatividad humana, una de las habilidades más genuinas y antiguas, se convierte ahora en una herramienta para hackear IA.

No estamos hablando de complejos ataques computacionales, sino de versos y metáforas capaces de confundir a algunos de los modelos más avanzados del mundo.

Esto marca un antes y un después en la conversación sobre seguridad en inteligencia artificial.

La industria tendrá que replantear cómo se entrena, cómo se protege y cómo se evalúa realmente a los modelos.

Conclusión

La poesía ha demostrado ser un caballo de Troya inesperado para las IA generativas. Y aunque este descubrimiento puede parecer anecdótico o incluso humorístico, sus implicaciones son profundas: los sistemas de seguridad de los modelos aún son vulnerables, inconsistentes y relativamente fáciles de evadir.

Si trabajas con IA o si tu empresa depende de ella, este tipo de investigaciones no deben tomarse a la ligera. Nos recuerdan que la inteligencia artificial necesita controles más sólidos, validación continua y una mayor supervisión humana. Porque la creatividad, incluso en forma de verso, también puede ser una herramienta para el cibercrimen.