Microsoft Copilot es ampliamente reconocida como una de las herramientas de productividad más potentes disponibles en la actualidad. Este innovador asistente de inteligencia artificial se encuentra integrado en todas las aplicaciones de Microsoft 365, como Word, Excel, PowerPoint, Teams, Outlook, entre otras. La visión de Microsoft al desarrollar Copilot es liberar a las personas de la monotonía de las tareas diarias y permitirles centrarse en abordar problemas de manera creativa.

Lo que distingue a Copilot de otras herramientas de inteligencia artificial, como ChatGPT, es su acceso completo a todo lo que uno haya trabajado dentro de Microsoft 365. Copilot puede buscar y recopilar datos de manera instantánea en todos los documentos, presentaciones, correos electrónicos, calendarios, notas y contactos del usuario.

No obstante, esto plantea un desafío importante para los equipos encargados de la seguridad de la información, ya que Copilot puede acceder a datos confidenciales que, en muchas ocasiones, están disponibles para todos los trabajadores. En promedio, aproximadamente el 10% de los datos de Microsoft 365 de una empresa están al alcance de todos los empleados.

Además, Copilot tiene la capacidad de generar rápidamente nuevos datos confidenciales que requieren protección. Antes de la era de la inteligencia artificial, la capacidad de los seres humanos para crear y compartir datos superaba ampliamente la capacidad de protegerlos, como lo demuestran las tendencias en violaciones de datos. La tecnología de inteligencia artificial generativa solo agrava este problema.

Existen numerosos aspectos a considerar en relación con la inteligencia artificial generativa, como el envenenamiento de modelos, los deepfakes, entre otros. Sin embargo, en este artículo, nos enfocaremos específicamente en la seguridad de los datos y en cómo su equipo puede garantizar una implementación segura de Copilot.

Te podrá interesar leer: Microsoft Copilot: Tu Compañero de IA en la Nube

Casos de uso de copilot en Microsoft 365

Los posibles usos de Microsoft Copilot en Microsoft 365 son prácticamente ilimitados, lo que explica por qué numerosos equipos de TI y seguridad están ansiosos por acceder a esta tecnología y preparar sus planes de implementación. Los beneficios en términos de productividad prometen ser significativos.

Por ejemplo, imagina que abres un documento en blanco en Word y le pides a Copilot que redacte una propuesta para un cliente, utilizando un conjunto de datos específico que puede incluir páginas de OneNote, presentaciones de PowerPoint y otros documentos de Office. En cuestión de segundos, obtendrás una propuesta completa y lista para su uso.

A continuación, te presentamos algunos ejemplos adicionales que Microsoft mencionó durante su evento de lanzamiento:

- En reuniones de Teams, Copilot puede unirse y, en tiempo real, resumir lo que se está debatiendo, capturar elementos de acción y señalar las preguntas que aún no se han respondido.

- En Outlook, Copilot puede ayudarlo a organizar su bandeja de entrada, priorizar correos electrónicos, resumir conversaciones y generar respuestas de manera automática.

- En Excel, Copilot puede analizar datos sin procesar y proporcionar información valiosa, identificar tendencias y ofrecer sugerencias.

Te podrá interesar leer: Descubre Cómo Activar y Aprovechar al Máximo CoPilot

¿Cómo funciona el copilot en Microsoft 365?

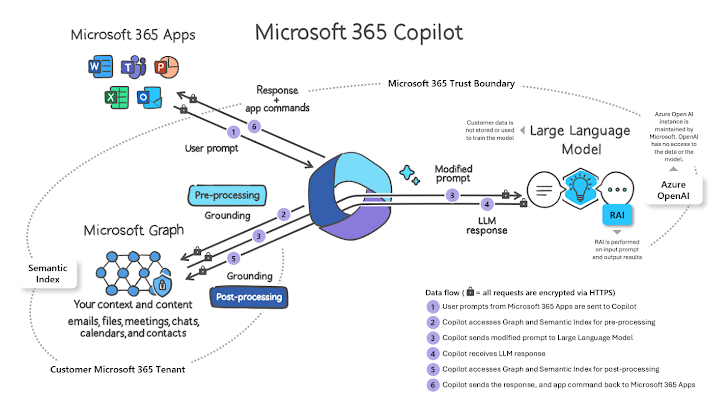

A continuación, te presentamos una simplificación de cómo opera Microsoft 365 Copilot:

- Un usuario ingresa un mensaje en una aplicación como Word, Outlook o PowerPoint.

- Microsoft recopila el contexto empresarial del usuario basado en sus permisos de Microsoft 365.

- El mensaje se envía al LLM (como GPT4) para generar una respuesta.

- Microsoft lleva a cabo comprobaciones de IA responsables después del proceso.

- Microsoft genera una respuesta y envía comandos a la aplicación de Microsoft 365.

Podría interesarte: Microsoft presenta Copilot en dispositivos Windows 10

Modelo de seguridad de Microsoft 365 Copilot

Respecto al modelo de seguridad de Microsoft 365 Copilot, existen consideraciones importantes:

Buenas noticias:

-

Aislamiento de inquilinos: Copilot utiliza exclusivamente datos del inquilino de Microsoft 365 del usuario actual y no accede a datos de otros inquilinos a los que el usuario pueda ser invitado ni de inquilinos configurados con sincronización entre inquilinos.

-

Límites del entrenamiento: Copilot no utiliza datos comerciales para entrenar los LLM fundamentales que utiliza para todos los inquilinos, por lo que no se expondrán los datos de propiedad en respuestas para otros usuarios de diferentes inquilinos.

Malas noticias:

-

Permisos: Copilot muestra todos los datos de la organización para los cuales los usuarios individuales tienen al menos permisos de visualización, lo que puede ser un desafío si las empresas no aplican privilegios mínimos de manera efectiva.

-

Etiquetas: El contenido generado por Copilot no hereda las etiquetas de confidencialidad de los archivos de los que obtiene su respuesta, lo que puede complicar el cumplimiento de políticas de DLP y cifrado.

-

Humanos: Las respuestas de Copilot no están garantizadas al 100% en cuanto a objetividad y seguridad, por lo que se requiere la revisión humana del contenido generado por la IA.

Te podrá interesar leer: Seguridad en Modelos de Lenguaje: Retos y Soluciones

Preparar la seguridad para Copilot

Aquí tienes algunos consejos de seguridad para usar Microsoft Copilot, una herramienta de inteligencia artificial:

-

Mantén tus Credenciales Seguras: Asegúrate de que tu cuenta y credenciales de Microsoft estén protegidas. Utiliza contraseñas fuertes y autenticación de dos factores (MFA).

-

Control de Acceso: Limita quién tiene acceso a Copilot en tu organización. Asegúrate de que solo las personas autorizadas puedan usarlo.

-

Actualizaciones y Parches: Mantén tu software, incluido Copilot, actualizado. Las actualizaciones suelen incluir parches de seguridad importantes.

-

Capacitación y Concienciación: Capacita a tu equipo sobre el uso seguro y responsable de la IA. Incluye temas como la privacidad de datos y el manejo ético de la información.

-

Gestión de Datos: Sé consciente de los datos que compartes con Copilot. Evita ingresar información confidencial o personal si no es necesario.

-

Monitoreo Continuo: Supervisa cómo se usa Copilot en tu entorno. Busca patrones inusuales que puedan indicar un uso indebido o un acceso no autorizado.

-

Políticas de Uso Aceptable: Establece políticas claras sobre qué se puede y qué no se puede hacer con Copilot. Esto incluye límites en el tipo de datos que se pueden procesar y cómo se deben manejar los resultados.

Recuerda, la seguridad en la IA no solo se trata de proteger la tecnología, sino también de usarla de manera responsable y ética.

En resumen, la seguridad en la inteligencia artificial generativa, especialmente en herramientas avanzadas como Microsoft Copilot, es un campo en constante evolución que requiere una vigilancia y adaptación continuas.

Mirando hacia el futuro, es evidente que el equilibrio entre aprovechar el poder de la IA generativa y mantener un entorno seguro y ético será un desafío continuo. Esto se debe a que la tecnología y sus aplicaciones están en constante evolución. Sin embargo, con un enfoque proactivo y colaborativo que involucre a desarrolladores, usuarios y legisladores, podemos no solo mitigar los riesgos sino también maximizar el potencial de la IA para transformar positivamente nuestras actividades diarias y profesionales.

En última instancia, la seguridad en la IA generativa no es solo una cuestión de implementar las mejores prácticas técnicas, sino también de fomentar una cultura de responsabilidad, respeto y curiosidad hacia lo que estas tecnologías pueden ofrecer. Al hacerlo, podemos garantizar que herramientas como Microsoft Copilot no solo sean potentes aliados en nuestras tareas, sino también compañeros seguros y confiables en nuestra continua búsqueda de innovación y excelencia.